| Sommaire |

I) Qu'est-ce qu'un logiciel libre : cadre juridique et historique du logiciel libre :

1- Définition d'un logiciel libre2- Les différents types de licences

A) Spécificités de l'économie logicielle

B) Les différents types de logiciels et leurs licences

3- Le cadre juridique des logiciels libres

A) La Free Software Foundation

B) La licence GPL

C) Le projet GNU

4- Historique du logiciel libre et principaux logiciels " libres "

A) Le modèle Unix

B) Les premiers systèmes libres

C) L'arrivée de Linux

D) Les principaux logiciels libres

II) Comment expliquer la réussite du modèle de développement " libre " ?

1) Un mode de développement coopératif et volontaire

(ou comment rendre performant le travail collectif d'individus isolés)

A) Un style de direction intelligent et fédérateur

B) L'importance d'une intelligence conceptuelle

2) Une haute qualité technique

A) La " loi de Linus "

B) La qualité comme seul objectif

3) Les autres facteurs de succès des logiciels libres

4) Les avantages intrinsèques des logiciels libres par rapport aux logiciels commerciaux

A) De multiples avantages…

B) …et quelques limites

III) Quelle viabilité pour le modèle économique basé sur les logiciels libres ?

1) Au niveau des éditeurs de logiciels

A) Les acteurs et leurs stratégies

B) Les limites de l'approche propriétaire

2) Au niveau des utilisateurs (entreprises)

A) Quelle compatibilité entre le monde du " libre " et celui de l'entreprise ?

B) Étude de trois scénarios de déploiement de logiciels en entreprise

C) Les limites de l'approche " logiciels libres " en entreprise

3) Le logiciel libre, une opportunité politique ?

A) Le logiciel libre, un régulateur de l'économie de marché

B) Une opportunité pour développer des industries logicielles indépendantes

IV) Interrogations et conjectures sur l'avenir du mouvement Open source :

1) Quel avenir économique pour les logiciels libres ?2) L'influence grandissante des multinationales dans le logiciel libre

3) La menace des brevets logiciels

- Traduction de la licence GPL

- Le premier post de Linus Torvalds

Introduction :

D'une part, comment expliquer le succès d'un mode de développement apparemment totalement désorganisé, sans hiérarchie ni contraintes d'aucune sorte sur ses membres, eux-mêmes totalement libres dans leurs contribution? Comment le travail collectif d'individus isolés, libérés de toute structure peut-il s'avérer performant au point de dépasser les modèles d'organisation extrêmement étudiés des industriels du logiciel?

D'autre part, comment ces logiciels peuvent-ils s'avérer performants et compétitifs dans le monde économique, pour lequel ils ne sont apparemment pas étudiés? Comment peuvent-ils présenter un quelconque avantage face à des produits soutenus par des structures commerciales très puissantes? Nous verrons qu'en plus d'offrir souvent un avantage technique, stratégique et financier, ces logiciels peuvent avoir des implications bien plus profondes dans la vie économique, tant au niveau des entreprises (éditrices ou utilisatrices) qu'au niveau des administrations ou même d'états entiers.

Ce mémoire a pour objectif d'expliquer comment les logiciels libres apportent un nouveau modèle d'organisation révolutionnaire, basé sur la mise en réseau du monde entier et sur une gestion particulière des rapports humains, et ensuite de montrer à quel point ils risquent de modifier considérablement l'économie logicielle et la stratégie de ses nombreux acteurs.

Pour cela, nous verrons d'abord en détail ce que sont les logiciels libres, d'où ils viennent et sur quels cadres juridiques ils s'appuient. Ensuite, dans une seconde partie, comment l'on peut expliquer la réussite du modèle de développement libre au niveau technique, d'où provient la performance d'un tel type d'organisation autogéré et laissé suivre une sorte d'évolution " darwiniste ". Pour suivre le sujet de ce mémoire, la troisième partie expliquera comment le logiciel libre peut pourtant s'avérer transposable à la sphère économique, tant pour les éditeurs logiciels que leurs clients, et même constituer une opportunité politique au niveau d'Etats. La quatrième partie sera davantage une réflexion sur l'avenir envisageable à long terme pour ce modèle, avec les potentialités qu'il recèle, mais également les menaces qui peuvent peser sur lui avec son développement économique.

Ce mémoire s'articule autour du logiciel libre. Il est donc nécessaire de commencer par en préciser la définition, mais aussi les cadres juridiques et historiques dans lesquels il s'inscrit.

De façon formelle, un logiciel se définit comme " l'ensemble des programmes, procédés et règles et éventuellement de la documentation, relatifs au fonctionnement d'un ensemble de traitement de données " (http://www.ccip.fr/irpi/faq/logiciel/definition.htm). Plus généralement, on pourra réduire ici cette définition à l'ensemble des instructions logiques indispensable au fonctionnement d'un ordinateur. Avec la démocratisation de l'informatique et la démultiplication de ses effets au travers de l'Internet, l'importance des logiciels n'a fait que croître, depuis leur apparition dans les années 60 jusqu'à la société de l'information que nous connaissons aujourd'hui.

Si n'importe qui peut concevoir un logiciel avec peu de moyens (un ordinateur et du savoir faire), la conception logicielle est aujourd'hui devenue une industrie très importante et dominée par quelques acteurs majeurs dont les logiciels sont dits " propriétaires ". En effet ces sociétés conservent l'entière propriété intellectuelle de leurs logiciels, distribués sous forme compilée (binaire exécutable) et leur utilisation est soumise à des conditions très précises. Se définissant par opposition au logiciel " propriétaire ", le "logiciel libre" se rapporte à la liberté des utilisateurs d'exécuter, de distribuer, d'étudier, de modifier et d'améliorer le logiciel au travers de son code source, l'ensemble des lignes de codes qui une fois compilées en langage machine, donneront le logiciel fini. Ces logiciels sont d'ailleurs généralement distribués sous forme de lignes de codes que l'utilisateur compilera au moment de l'installation. Plus précisément, on distingue trois niveaux de libertés pour le logiciel libre:

Ces contrats de licence ont d'ailleurs de nombreux aspects très particuliers. Les éditeurs logiciels cèdent des licences d'exploitation propriétaires permettant à leur client d'utiliser sous certaines conditions leur produit. En aucun cas les clients ne possèdent le logiciel, seulement le droit de l'utiliser. De plus aucune garantie quant à son fonctionnement n'est présente, et en cas de perte de données ou de panne liée au logiciel, le client ne pourra se retourner contre l'éditeur, comme le montre un extrait de licence tout à fait courant ci-dessous. Ce qui pourrait sembler abusif dans d'autre secteurs d'activité est ici justifié juridiquement par le caractère " artistique " des logiciels, qui en tant qu'œuvres ne peuvent donc être associés à aucune garantie. La responsabilité de l'éditeur n'est donc jamais engagée, seule sa caution morale certifiant que le logiciel est fiable peut rassurer le client.

Extrait d'un contrat de license propriétaire (Netscape 4.7) :

Ce type de logiciel est un logiciel libre, dont les conditions de distribution interdisent aux distributeurs d'y ajouter des restrictions d'utilisation, même s'ils y ont apporté des modifications. Ceci veut dire que chaque copie du logiciel, même modifié, doit être un logiciel libre.

Par opposition au copyright, ce type de licence (la plus courante du " libre ") vise à éviter l'apparition de restrictions quant au statut du logiciel au cours de son développement. Une fois qu'un logiciel est copylefté, ses évolutions ne pourront être revendiquées par qui que ce soit, et son code source restera toujours ouvert et librement modifiable. Le concept de copyleft est un concept général. Pour l'appliquer à un programme, il existe un ensemble de termes relatifs à la distribution, ce qui fait que concrètement il existe plusieurs façon d'écrire les conditions de distribution. Seul l'objectif reste le même.

Un cas particulier : LOGICIEL COUVERT PAR LA GPL :

La " GNU-GPL (Licence Publique Générale) (20 K caractères) " (appellation officielle) est un ensemble spécifique de conditions de distribution pour copylefter un programme. Le projet GNU (système d'exploitation complet, inspiré d'UNIX mais différent de Linux, et libre) l'utilise pour la distribution de la plupart des logiciels GNU, dont le célèbre Linux qui en est dérivé. Une grande majorité des logiciels dits " libres " est en fait sous licence GPL.

Le logiciel libre soumis à restrictions, est défini par l'auteur avec la permission de le redistribuer, de le modifier, et d'y ajouter d'autres restrictions.

Si un programme est libre, mais soumis à restrictions, certaines versions modifiées peuvent ne plus être "libres" du tout. Une société informatique peut compiler un programme, avec ou sans modifications, et distribuer le fichier exécutable, en tant que son propre produit payant et dont la redistribution, ou les modifications ne peuvent être réalisées sans son accord formel.

Le système X window (gestion de l'interface graphique : menus, fenêtres... pour Unix) en est un exemple. Le consortium X distribue le X11 avec des conditions de distribution telles qu'il en fait un logiciel libre mais soumis à restrictions. L'accès à des copies d'X11 est libre. Toutefois, il existe aussi des copies "non libres", et il existe également des stations de travail, ainsi que des cartes graphiques PC pour lesquelles seules des versions non libres fonctionnent. Dans le cas d'utilisation de ce matériel spécifique, X11 n'est alors plus un logiciel libre.

Cas particulier : LOGICIEL DU DOMAINE PUBLIC

Logiciel du domaine public veut dire logiciel non soumis aux droits d'auteurs. C'est un cas spécial du logiciel libre "non-copylefté", ce qui veut dire que certaines copies, ou certains versions modifiées, ne sont pas du tout gratuites. La différence avec un logiciel freeware est que le code source est disponible, généralement pour en permettre l'étude. Les seuls logiciels du domaine public sont ceux qui y ont été explicitement placés par leurs auteurs, en partie à cause du développement récent de l'informatique, et surtout du vieillissement rapide des logiciels utiles.

Parfois, le terme "du domaine public" est utilisé d'une façon large pour dire "libre" ou "disponible gratuitement". Cependant, "domaine public" est un terme légal qui signifie avant tout que le logiciel n'est pas soumis à des droits de copyright. Personne ne peut donc en demander des royalties, sauf en cas de modification significative.

On trouve des exemples de logiciels du domaine public sur www.idris.fr/su/Produits_Publics/tab_Prod_public.html

LOGICIEL SEMI-LIBRE :

Le logiciel semi-libre n'est pas un logiciel entièrement libre, mais y sont autorisés : l'utilisation, la copie, la distribution, la modification, (y compris la distribution des versions modifiées), à condition que ce soit dans le cadre d'un usage privé, et à des fins non lucratives. P.G.P. est l'exemple d'un programme semi-libre. Son utilisation commerciale nécessite de payer une licence à Network Associates International, alors que le code source en est librement utilisable et vérifiable. Des versions " copyleftées " en ont d'ailleurs été dérivées telles que GnuPG.

* En face, la famille des logiciels propriétaires :

La majorité des logiciels reste encore propriétaire. Le logiciel propriétaire n'est par définition ni libre, ni semi-libre. Son utilisation, redistribution ou modification sont interdites, ou exigent une autorisation spécifique. Ses conditions d'utilisation sont généralement tellement restrictives, qu'une utilisation libre est impossible. Chaque usage possible du logiciel est détaillé dans sa licence d'exploitation. Avant tout, l'auteur conserve la plupart des droits associés au logiciel.

On distingue là aussi plusieurs types de licences propriétaires :

FREEWARE (ou graticiel en français) :

Un logiciel Freeware n'est pas soumis au paiement d'une licence ou de quoi que ce soit (sauf parfois pour une utilisation professionnelle), son utilisation et sa distribution sont encouragées. Le but d'un logiciel mis sous une licence de type Freeware est évidemment de gagner un grand nombre d'utilisateurs, ce qu'une version payante ne pourrait faire. Par contre l'auteur conserve les sources de son programme et tous les droits sur ce dernier. Il est donc le seul à pouvoir le modifier, voire en exploiter des développements ultérieurs. C'est le cas de logiciels très connus comme Winamp ou Napster, dont le succès se base avant tout sur leur part de marché et la base d'utilisateurs actifs. Les sociétés les exploitant les offrent gratuitement en se rétribuant sur d'autres services associés qui sont alors payant, comme la publicité sur le site de téléchargement ou l'intégration de fonctionnalités préférentielles dans le freeware.

En résumé pour les freewares :

Le shareware est un logiciel dont l'utilisation est soumise au paiement de royalties à l'éditeur. Les Shareware ne sont pas des logiciels libres ou même semi-libres pour deux raisons:

- Avec le shareware, il n'est pas permis d'effectuer de copie du logiciel et pour conserver le logiciel installé, une licence doit être achetée pour rester dans la légalité, y compris pour des activités non lucratives (en réalité de nombreuses personnes utilisent ces logiciels sans payer, mais ce n'est pas permis, seulement toléré de manière officieuse).

En résumé pour les sharewares :

Le logiciel commercial est un logiciel développé par une entreprise dont le but est de se faire payer par l'utilisateur. Les logiciels commerciaux traditionnels sont placés sous le contrôle de licences d'utilisation variées dont l'objectif est d'en limiter la reproduction et les conditions d'utilisation. Légalement, l'utilisation d'un partagiciel sans paiement de la licence est souvent considéré comme assimilable à une violation du droit d'auteur.

Par exemple, le compilateur GNU Ada est toujours distribué sous les termes de la GNU GPL (voir I) 3 B p.15), et chaque copie est libre; mais ses développeurs vendent des contrats de support. Concrètement, si certains clients peuvent préférer un compilateur commercial qui leur semble plus sûr qu'un logiciel libre, le vendeur du logiciel pourra répondre que GNU Ada est un compilateur commercial mais que c'est également un logiciel libre.

Ce statut particulier des logiciels libres distribués de façon commerciale ne pose aucun problème à la communauté des développeurs " libres ", généralement pointilleuse au niveau des licences, au point de développer à partir de rien des versions entièrement libres d'applications, comme le gestionnaire de fenêtres Gnome pour Linux (car KDE utilisait des librairies Qt alors non libres). En effet, vu que la vente de ce produit reste secondaire au fait qu'il soit librement disponible et modifiable, l'élargissement de l'audience du logiciel libre par ce développement commercial est plutôt considérée comme bénéfique, comme nous le verrons en détail plus loin

NB : D'autres licences propriétaires, parfois étonnantes, existent également. Un Cardware ne demande à son utilisateur que d'envoyer une carte postale à son auteur, comme STUDIOS qui est un éditeur de diaporamas...

Pour comprendre sur quelles règles juridiques se base le logiciel " libre ", il est nécessaire de décrire le rôle de la Free Software Foundation, de la licence GNU-GPL, ainsi que l'effet fédérateur du projet GNU que ces deux dernières ont amorcé. Il est à noter que si d'autres bases juridiques existent pour d'autres catégories de logiciels libres, la licence GPL est devenue la référence pour l'immense majorité des programmes en Open Source.

Ces licences spécifient que les logiciels GNU peuvent être copiés, modifiés et redistribués de quelque manière que ce soit, aussi longtemps que les sources sont disponibles gratuitement. Une traduction française de la GPL est disponible sur http://www.cam.org/~trot/cpa/gpl_fra.html et en annexe p64 tandis que l'originale en anglais se trouve sur http://www.gnu.org/copyleft/gpl.txt .

Le gros avantage des logiciels distribués selon ces conditions est que si quelqu'un désire les améliorer, tout d'abord il pourra le faire, mais également distribuer (gratuitement ou non) la nouvelle version. De ce fait, tout le monde en profitera et pourra à son tour l'améliorer. Cette méthode de développement conduit à d'excellents programmes écrits par des dizaines de personnes différentes et crée ainsi un cercle vertueux dans le développement du logiciel. Personne ne peut s'approprier un programme placé sous GPL.

Extrait de la GPL :

Par exemple, si vous distribuez des copies d'un tel programme, gratuitement ou non, vous devez transmettre aux utilisateurs tous les droits que vous possédez. Vous devez vous assurer qu'ils reçoivent ou qu'il peuvent se procurer le code source. Vous devez leur montrer cette licence afin qu'ils soient eux aussi au courant de leurs droits. "

En effet, AT&T a largement distribué Unix, et en raison de la conception même du système d'exploitation (multi-plateformes), la compagnie devait effectuer cette distribution sous forme de code source C. Si le client avait des problèmes avec Unix (bug, fonctionnalité manquante), c'était à lui de plonger dans le code source afin d'y apporter les modifications nécessaires. Mais AT&T a conservé la propriété du code source et a contraint les utilisateurs à acheter des licences qui ont interdit la redistribution et la création de travaux dérivés. Les gros centres informatiques, industriels ou académiques, pouvaient se permettre d'acheter de telles licences, mais pas les individus qui en appréciaient pourtant les nombreux avantages. En même temps, les restrictions des licences interdisaient aussi à la communauté des utilisateurs qui utilisaient Unix de l'améliorer autrement que de façon épisodique. Et comme les programmeurs à travers le monde commençaient à aspirer à une révolution de l'ordinateur personnel (et même à l'attendre), le statut " non libre " d'Unix a commencé à devenir une source de problèmes.

Cependant, certains auteurs universitaires de logiciels se sont progressivement convaincus que, même sans les importantes structures associées à la production industrielle et commerciale, ils étaient capables de produire des logiciels de qualité comparable et pouvant rivaliser avec leurs concurrents "professionnels".

Richard Stallman, alors employé au laboratoire d'intelligence du MIT, fut le premier à imaginer un projet de reconception et d'amélioration d'un système d'exploitation composé de vrais logiciels libres, basé sur le partage de connaissances et la coopération entre programmeurs. La raison d'être du logiciel libre serait la liberté pour tous de modifier et redistribuer de tels logiciels, avec pour seule restriction de ne pas réduire les droits de ceux à qui ils seraient redistribués. La gratuité ne faisait pas partie de ses objectifs, bien qu'elle soit une conséquence pratique de la liberté du code source. Par ce système d'ouverture, Stallman voulait que le logiciel libre puisse devenir un projet auto-organisé, s'enrichissant de lui-même, dans lequel aucune amélioration ne serait perdue pour d'autres à travers les copyrights. Ce système a été nommé GNU, signifiant " GNU is Not Unix " pour marquer la différence fondamentale entre ces deux systèmes pourtant similaires sur de nombreux points. Malgré des doutes sur la conception fondamentale d'Unix (système " pas trop mauvais " d'après Stallman) et sur ses conditions de distribution restrictives, GNU était conçu pour bénéficier de la large (bien que non libre) distribution de sources d'Unix, connues par un grand nombre de programmeurs. Richard Stallman a commencé le projet GNU en écrivant lui-même des composants du système final qui étaient aussi conçus pour fonctionner sans modification sur les systèmes Unix existants. Le développement des outils GNU pouvait ainsi se faire directement dans l'environnement des universités et des autres centres de calcul avancé à travers le monde.

Pour mener a bien un projet d'une telle ampleur, il fallait parvenir à recruter, organiser et motiver un grand nombre de programmeurs volontaires qui construiraient tous les outils nécessaire au système d'exploitation. Pour cela, des cadres juridiques clairs ont dès le début été mis en place comme nous l'avons vu avec la Free Software Foundation et la licence GPL. Cependant ce mode de production ne s'est véritablement exprimé qu'à partir de 1991 avec le projet de Linus Torvalds, un étudiant en informatique de l'université d'Helsinki, qui a commencé le projet Linux et a vraiment dynamisé la vision et l'énergie du logiciel libre.

En 1994, Linux a atteint la version 1.0, représentant un noyau utilisable en production et le niveau 2.0 a été atteint en 1996. En 1998, avec le noyau à la version 2.2.0 et disponible non seulement pour les machines à base de x86 (= PC équipé d'un processeur Intel) mais pour toute une variété d'autres architectures de machines, GNU/Linux (soit la combinaison du noyau Linux et des très nombreux composants du projet GNU) et Windows NT étaient les deux seuls systèmes d'exploitation du monde à gagner des parts de marché. Une évaluation interne à Microsoft ayant filtré en octobre 1998 (et ensuite reconnue comme authentique par l'entreprise…mais peut-être délibérément dans le cadre du procès anti-trust en cours) concluait que " Linux représente un UNIX qui sort du rang, en qui on fait confiance pour des missions d'applications critiques et (ce qui est en partie dû au code source [sic] ouvert) et qui a une crédibilité sur le long terme qui excède celle de nombreux systèmes d'exploitation compétitifs. " (http://www.opensource.org/halloween/halloween1.html). Les systèmes GNU/Linux sont maintenant utilisés à travers le monde, fonctionnant partout, faisant office de serveurs web dans des sites de commerce électronique majeurs ou en tant que clusters dédiés à l'infrastructure réseau de centres de paiement de banques. On trouve aussi GNU/Linux à des endroits surprenants, comme dans la navette de l'espace ou jusqu'à récemment encore sur les serveurs de Microsoft. Les évaluations de l'industrie sur la fiabilité des systèmes Unix ont montré de manière répétée que Linux est de loin le noyau Unix le plus stable et le plus fiable, dont la fiabilité est seulement dépassée par les outils GNU eux-mêmes. GNU/Linux ne dépasse pas seulement les versions propriétaires d'Unix pour les PC dans les tests de performances, mais est renommé pour sa capacité à fonctionner, sans perturbation et sans plainte, pendant des mois sur des environnements de haut volume et de hautesollicitation sans se planter.

Il existe de très nombreux logiciels libres de toutes tailles, et pour toutes les plates-formes, bien que les plates-formes de type Unix, incluant Linux et FreeBSD, restent les plus nombreuses. Nombre de logiciels libres à succès (Emacs, TeX, GCC, PERL, Gimp, par exemple), développés initialement dans un environnement Unix, ont été ultérieurement portés sur les plates-formes Macintosh et Windows, ainsi que nombre de petits utilitaires classiques de l'environnement Unix. La variété de ces logiciels est immense, traitement de texte ou d'images, télécommunications, courrier, logiciels scientifiques, compilateurs... Sans entrer dans une étude exhaustive, il faut savoir que de nombreuses collections organisées sont disponibles dans les archives publiques de l'Internet, ainsi que dans des collections de CDROM à bas prix, mais au contenu très riche. La Free Software Foundation recense d'ailleurs pour chaque pays les moyens de se procurer les principaux logiciels libres, ainsi que leur sources, pour le coût du support et de l'envoi. En France par exemple, on trouve des CD-rom pressés de la plupart des distributions Linux et BSD sur www.ikarios.com pour moins de 20F.

Plus en détail, on peut donc distinguer quelques catégories de logiciels libres:

Plusieurs composants du mouvement du logiciel libre ont également été couronnés de succès. Apache, le serveur web le plus répandu (taux d'occupation des serveurs web : 55% seul et 7O% avec ses dérivés, selon les statistiques de l'organisme Netcraft), est libre, de même que Perl et plus récemment PHP, deux langages de programmation très largement utilisés dans les sites web sophistiqués. Netscape Communications distribue désormais son navigateur Netscape Communicator 6.0 en tant que logiciel libre, sous une licence proche de la Licence Générale Publique de la Free Software Foundation. De grands constructeurs de PC, comme IBM ou Compaq, ont annoncé des projets de distribution de GNU/Linux ou sont déjà en train en train de le distribuer en tant qu'option pour le client sur leurs PC de haut de gamme destinés à une utilisation en tant que serveurs web ou de partage de fichiers. Samba, un programme qui permet aux ordinateurs sous système libre de se comporter en tant que serveurs de fichiers Windows NT, est mondialement utilisé comme une alternative à Windows NT Server. De très nombreuses petites applications pour sites web connaissent aussi un franc succès, comme par exemple PHPNuke (script PHP permettant de créer et gérer un site portail complet), ou Phorum (forum web).

Pour mieux comprendre le succès des logiciels libres, il est important de revenir sur leur mode de production original et sur ce qui en fait l'efficacité.

Le mode de développement des logiciels libres est particulièrement intéressant car il s'inscrit dans une logique totalement différente des logiciels propriétaires. Là où les grands éditeurs de logiciels mettent en place des cahiers des charges et " roadmaps " très détaillés, où le partage des tâches très étudié et l'organisation doivent être sans défauts, les logiciels libres semblent justement s'affranchir d'une bonne partie de ces contraintes. A un modèle très centralisé et hiérarchisé s'oppose une structure totalement éclatée, basée sur le volontariat et unie seulement par les moyens de communications de l'Internet De plus la recherche de profit reste initialement très secondaire dans le logiciel libre, bien que ceci soit à nuancer comme nous le verrons dans la partie III, alors qu'elle reste la raison d'être des éditeurs propriétaires.

Il est intéressant d'opposer ces deux mondes, qu'Eric S. Raymond illustre en comparant le logiciel propriétaire à une cathédrale et le logiciel libre à un bazar :

Dans cette partie, nous nous limiterons à l'exemple du système d'exploitation Linux en tant que modèle de développement, d'une part vu sa place majeure dans le logiciel libre et sa popularité actuelle, d'autre part parce que c'est un des exemples les plus significatifs en termes de modèle de développement d'un logiciel libre.

Linux fut en effet le premier projet à faire un effort conscient et déterminé pour utiliser le monde entier comme réservoir de talent. Linux reste très lié au développement de l'Internet : ses premières ébauches datent de l'apparition du World Wide Web (1991), et son développement massif de 1994, lorsque l'intérêt général accordé à l'Internet et l'industrie des fournisseurs d'accès ont décollé. Linus Torvalds fut un des premiers à comprendre comment se servir des nouvelles règles rendues possibles par la démocratisation d'Internet, et à les utiliser dans le développement d'un logiciel complexe. Même si le faible coût d'utilisation du net a joué pour que le modèle Linux se développe, il y a surtout un autre facteur vital: le développement d'un style de direction de projet et d'un ensemble de coutumes de coopération qui permettaient aux développeurs d'attirer des co-développeurs et de rentabiliser au maximum ce nouveau média.

Voyons donc quels sont ce style de direction et ces coutumes :

Basés sur le volontariat, les rapports entre développeurs se caractérisent tout d'abord par l'absence de rapports de force. Même si c'était le cas, la direction par coercition ne produirait pas les résultats très significatifs qu'on peut observer. Pour l'illustrer, Gerald Weinberg (The Psychology Of Computer Programming (la psychologie de la programmation des ordinateurs) (New York, Van Nostrand Reinhold 1971)) cite l'autobiographie de Pyotr Alexeyvitch Kropotkine, anarchiste russe du 19ème siècle, ``Mémoires d'un révolutionnaire'':

" L'effort soutenu de nombreuses volontés travaillant dans le même sens " est exactement ce qu'un projet comme Linux demande, et le " principe de commandement et la discipline " sont en effet impossible à appliquer aux volontaires (" hommes libres ") liés par les structures horizontales (et d'ailleurs anarchiques) de l'Internet. Pour avancer et se confronter les uns aux autres de manière efficace, les bidouilleurs qui cherchent à prendre la tête d'un projet de collaboration commune doivent apprendre à recruter et à insuffler de l'énergie dans les communautés d'intérêts convergents à la manière suggérée par le "principe de bonne intelligence" de Kropotkine. Ils doivent s'inspirer de l'exemple de Linus Torvalds.

En effet, Linus Torvalds a su se positionner comme le leader incontestable du projet Linux où le développement est essentiellement fait par d'autres. S'il a acquis sa légitimité en partie du fait d'avoir écrit les bases du noyau Linux, son leadership provient surtout de sa capacité a avoir su fédérer les égoïsmes individuels des programmeurs volontaires pour réaliser des tâches impossibles sans une coopération soutenue. On peut rapprocher le monde Linux des systèmes adaptatifs en biologie et en économie, vu que sous de nombreux aspects il se comporte comme un marché libre ou un écosystème, avec des ensembles d'agents égoïstes qui tentent de maximiser une utilité (celle du logiciel). Cela produit un ordre spontané, se corrigeant de lui-même, plus élaboré et plus efficace que toute planification centralisée n'aurait pu l'être, en accord avec le principe de bonne intelligence. L'utilité que les développeurs de logiciels libres maximisent n'est pas économique, c'est en fait leur propre satisfaction et leur réputation au sein des autres bidouilleurs. Si leur motivation peut sembler altruiste, il ne faut pas oublier que l'altruisme est en soi une forme d'égoïsme pour l'altruiste. C'est une façon de prouver que ses capacités individuelles dépassent d'une certaine manière celles des autres dans un domaine qui leur tient à cœur et où les performances sont réellement mesurables et comparables. Les cultures volontaires qui fonctionnent sur ce principes sont fréquentes, on les retrouve par exemple sur les forums de discussions techniques ou d'une certaine façon à l'origine de tout acte de don (car donner c'est aussi s'enrichir de ce qu'on donne!).

Le projet Linux montre qu'en flattant à bon escient l'ego de beaucoup d'autres bidouilleurs, un coordinateur-développeur fort peut utiliser l'Internet pour tirer parti du fait d'avoir énormément de co-développeurs sans que le projet ne s'effondre dans le chaos.

Le chef ou coordinateur d'un projet décentralisé et non hiérarchisé doit également être bon en relations humaines et avoir un bon contact. Pour construire une communauté de développement, il est essentiel séduire les gens, de susciter leur intérêt, et de les encourager constamment pour leurs efforts. La personnalité projetée compte énormément, et ce n'est pas surprenant que les principaux " gourous " comme Torvalds soient " de chics types qu'on apprécie volontiers et qu'on a envie d'aider " (d'après Eric S. Raymond). Ainsi une communauté de contributeurs animée par une forte motivation a tendance à se créer d'elle-même, hors de toute structure coercitive.

Pour qu'un projet rallie les développeurs, il est essentiel que deux points soient respectés au niveau de la conception : d'une part que le projet suscite l'adhésion d'un grand nombre de développeurs, et d'autre part que son développement soit cohérent avec ses objectifs, sans se fourvoyer dans des impasses de développement.

Le développement d'un logiciel libre correspond à la recherche d'un idéal pour ses multiples contributeurs. Tous ces efforts désintéressés financièrement ne peuvent se faire qu'en étant motivés par un but ultime, au delà de l'ajout d'une fonctionnalité particulière que recherchaient les nouveaux contributeurs et qui a décidé de leur engagement. Richard Stallman a par exemple d'abord réagi au fait qu'il ne pouvait obtenir d'Hewlett Packard les spécifications matérielles nécessaires pour écrire un pilote d'imprimante qui lui manquait, puis ceci a alimenté le rêve d'un système totalement ouvert et libre, pour lequel il s'investit depuis vingt ans. Comme pour la plupart des développeurs, la motivation n'est pas uniquement de combler ce qui leur semble une lacune dans un logiciel libre ou propriétaire, mais bien plus de contribuer à un projet qui leur tient à cœur, une sorte de " chef d'œuvre ", de perfection logicielle, dont ils seraient totalement propriétaires au même titre que n'importe qui d'autre. Pour comprendre cela, il faut se rappeler que les bidouilleurs bénévoles ont quasiment tous une culture bien plus scientifique qu'économique. Pour eux seule la qualité technique ou intellectuelle fonde la valeur d'un logiciel, tout comme la recherche de la " Vérité " fait partie de la culture scientifique.

Un logiciel libre se développera d'autant plus vite qu'il motive un grand nombre de contributeurs actifs - pas forcément d'utilisateurs finaux même si les deux sont souvent liés. Pour initier un travail de développement en communauté, le projet doit présenter une promesse plausible. Le programme ne doit pas nécessairement fonctionner très bien. Il peut être grossier, bogué, incomplet, et mal documenté, mais il ne doit pas manquer de convaincre des co-développeurs potentiels qu'il peut évoluer en quelque chose de vraiment bien dans un futur pas trop lointain.

Pour être performante, une communauté dispersée ne doit pas seulement être fédérée autour d'un idéal commun, il faut aussi que ses efforts soient toujours coordonnés dans la meilleure direction afin d'éviter les impasses conceptuelles et de décourager les contributeurs. Si le style de direction doit savoir concentrer des égoïsmes particuliers, il faut ensuite qu'il maintienne cette cohésion en sachant toujours choisir les meilleures orientations pour la réussite du projet. Il ne peut se contenter d'exalter les talents d'autres programmeurs, mais doit aussi faire preuve d'un talent exceptionnel au niveau de la conception. Le coordinateur ne doit pas spécialement être un programmeur particulièrement brillant, mais doit absolument savoir reconnaître les bonnes idées de conception des autres. A ce titre, Linus Torvalds peut être considéré comme une personne extrêmement compétente pour savoir choisir les meilleures voies de développement qu'on lui soumet, pour trouver le chemin de moindre effort reliant A à B, et pour éviter les bogues ou autres impasses de développement. La conception de Linux est entièrement imprégnée de ces qualités et reflète l'approche de Linus Torvalds : conservatrice et simplificatrice. Comme il le rappelle lui-même, une entité reconnue de tous doit s'occuper de faire les bons choix parmi les multiples contributions pour garantir un développement sûr. Concrètement, un petit nombre de personnes très spécialisées se partagent la gestion des différentes parties de Linux, et directement avec Linus Torvalds, décident des orientations stratégiques du développement.

" Cette idée d' " absence de propriétaire " signifie que seule une entité peut vraiment avoir du succès en développant Linux --- l'entité à qui on fait confiance pour faire les bons choix. Et telles que les choses se présentent à l'heure actuelle, je suis l'unique personne/entité qui jouit d'un tel degré de confiance. Et même si quelqu'un pensait que je travaille mal (ce qui est assez rare) et que cette personne décide " il faut vraiment que je corrige cette fonctionnalité ", il lui sera très difficile de convaincre tout le monde qu'elle en est capable.

Le chaos peut résulter de tout ceci, mais en même temps, ce système intègre certains mécanismes qui le rendent très stable. Mais il faut vraiment être très bon pour prendre en charge le développement. Savoir que la meilleure personne sera là pour s'en occuper est exactement le genre de sécurité dont on a besoin dans un réseau de développement. "

Ces principes opposés au mode de production des logiciels propriétaires sont aussi directement responsable de la stabilité reconnue et de la robustesse du logiciel libre, qui découle de ce qu'Éric Raymond appelle " la loi de Linux " : avec suffisamment d'yeux, tous les bugs disparaissent. En pratique, l'accès au code source signifie que tout le monde peut théoriquement identifier et résoudre soi-même les problèmes rencontrés. Et par l'effet démultiplicateur du nombre d'utilisateurs actifs, l'utilisateur final n'est quasiment jamais confronté à un problème non résolu par d'autres. L'effet de masse peut s'exprimer de façon très positive en ce qui concerne la qualité des logiciels dans un modèle de développement en open source.

(``Given enough eyeballs, all bugs are shallow.'' I dub this: ``Linus's Law''.)

Un nombre plus élevé d'utilisateurs augmente directement la qualité du logiciel car l'ajout de nouveaux utilisateurs introduit de nouvelles manières de pousser le programme dans ses derniers retranchements par la grande diversité des contraintes auxquelles il doit répondre. Ce système est également utilisé par l'industrie logicielle propriétaire, mais à échelle bien plus réduite, les quelques bêta testeurs n'ayant aucun accès au code source et se contentant de rapporter les bugs constatés. Avec les logiciels libres, tout utilisateur peut devenir bêta testeur et cet effet est encore amplifié quand les utilisateurs se trouvent être des co-développeurs. Chacun d'entre eux aura une manière personnelle de déboguer le logiciel et d'en rechercher les faiblesses. Par l'ouverture du code source et la liberté de le modifier, toute personne compétente en informatique pourra elle-même corriger le bogue à sa façon et soumettre son travail au responsable du développement. L'absence de hiérarchie dans ce modèle d'optimisation est plutôt un avantage en supprimant les barrières entre utilisateurs et concepteurs. Tout dépend là aussi de la personnalité du responsable du logiciel et de sa capacité à savoir fédérer et canaliser les multiples contributions qui lui parviennent. Chacune d'entre-elles est un pas supplémentaire vers la qualité du logiciel. Cette caractéristique particulière des utilisateurs développeurs rappelle qu'à la base, le principe du logiciel libre a été conçu par des informaticiens pour des informaticiens, d'où l'important taux d'utilisateurs actifs et impliqués dans le développement et le débogage.

Cette absence d'organisation dans l'optimisation du logiciel pourrait apparaître comme une faiblesse, tout comme l'absence apparente de structure et partage des tâches bien défini l'était en théorie au niveau de la conception. En pratique, le monde Linux n'est quasiment pas affecté par la perte théorique d'efficacité qui découle du fait que plusieurs débogueurs travaillent sur la même chose au même moment. L'une des conséquences de la politique du "distribuez tôt, mettez à jour souvent" est de minimiser les pertes de ce type en propageant au plus vite les corrections qui sont revenues au coordinateur. Ainsi, bénéficier de nouveaux bêta-testeurs ne réduit pas la complexité du bogue le plus profond pour le développeur, mais cela augmente la probabilité que l'approche et les compétences d'un bêta-testeur seront adaptées au problème de telle sorte que ce bogue lui saute aux yeux.

De façon empirique, on peut soutenir que si la "Loi de Linus" était fausse, alors tout système aussi complexe que le noyau Linux et soumis aux bidouilles simultanées d'autant de personnes, aurait dû finir par s'effondrer sous le poids des interactions néfastes et imprévues, de bogues profonds non découverts. D'un autre côté, l'absence relative de bogues dans Linux donne un argument de poids à cette " loi ".

Mais un minimum d'organisation existe pourtant dans le développement de Linux. Au cas où il y aurait des bogues sérieux, les versions du noyau Linux sont numérotées de telle sorte que des utilisateurs potentiels peuvent faire le choix d'utiliser la dernière version désignée comme étant stable, ou de profiter des dernières innovations en courant le risque que quelques bogues accompagnent les nouvelles fonctionnalités. La dernière version stable du noyau de Linux est actuellement la 2.4.3, et la version de développement la 2.4.4. Même si cette tactique n'est pas encore formellement imitée par la plupart des bidouilleurs Linux qui ne classent pas forcément leurs versions comme stable ou non, le fait d'avoir une alternative rend les deux choix séduisants.

Dans la programmation du point de vue propriétaire, les bogues et les problèmes de développement représentent des phénomènes difficiles, fastidieux et extrêmement longs à identifier et résoudre. Il faut à quelques bêta testeurs triés sur le volet des mois d'observations minutieuses avant de bien vouloir se laisser convaincre que tous les bogues ont été éliminés, d'où les longs intervalles séparant les mises à jour, et l'inévitable présence de défauts plus ou moins contraignants.

Un facteur marquant de l'opposition entre les univers du logiciel libre et du logiciel propriétaire est l'absence de marketing et de toute promotion économique. Ceci rend le succès d'un logiciel libre directement dépendant de ses qualités techniques, ignorant d'autres facteurs très présent dans le monde propriétaire comme la publicité, la promotion commerciale ou encore le lobbying qui peuvent faire passer la qualité objective derrière des facteurs plus subjectifs.

Ceci permet d'expliquer pourquoi, à l'inverse d'un grand nombre de sociétés logicielles aux produits pourtant innovateurs tués par la concurrence commerciale, un logiciel libre n'a aucune contrainte en terme de développement si ce n'est la qualité. Peu importe le respect des échéances, ou la conquête de nouveaux marchés, le seul intérêt du logiciel est de remplir son rôle technique et de satisfaire des besoins exprimés par ses propres utilisateurs. Les sorties de nouveaux noyaux pour Linux sont souvent repoussées jusqu'à ce que le nouveau donne satisfaction (cependant certaines distributions commerciales de Linux peuvent avoir tendance à sortir de nouvelles versions pas forcément éprouvées pour répondre à la pression concurrentielle, ce qui souligne encore plus les effets pervers de la pression commerciale dans le domaine logiciel). Certaines fonctionnalités plutôt marketing sont absentes, alors que des logiciels propriétaires similaires s'en servent abondamment (par exemple aucune publicité liée n'apparaît lors de l'installation)… L'apparence cède la place au coté technique pur et dur, particulièrement dans les versions non commerciales de logiciels libres (comme la distribution Debian ou FreeBSD). De plus les logiciels libres n'ont pas à craindre la concurrence commerciale, s'étant volontairement placé hors de cette sphère où la valeur se base sur la propriété intellectuelle du code source.

Cependant, ce n'est pas parce qu'un logiciel est libre qu'il est forcément de bonne qualité. Son code source aura beau être disponible, si en dehors des auteurs personne d'autre ne va l'examiner de près, la différence avec les logiciels du domaine public se réduit fortement. Si des projets tels que Linux ou Apache ont eu le succès qu'on leur connaît, le fait d'avoir été libres a été indispensable mais pas suffisant. Dans les deux cas, ces logiciels ont dû leur succès à une communauté fédérée à la fois par un leader et d'un rêve commun. Dans le cas de Linux, ce rêve a été de se créer son propre système d'exploitation.

On peut y opposer le fait que les milliers de développeurs professionnels des grands éditeurs commerciaux constituent une force très importante avec le soutien d'instituts de recherche et d'investissements très lourds. Cependant l'effet de masse des développeurs libres et l'amélioration permanente des logiciels ouverts reste bien plus efficace, du fait de la collaboration sur une échelle bien plus grande et sans doute de l'absence d'autre objectif que la qualité. Une comparaison a été faite, disant que quels que soient ses moyens, aucune entreprise logicielle ne pouvait lutter contre les talents combinés des meilleurs programmeurs de la planète. En effet, les communautés de logiciel libre peuvent mettre sur le problème un temps humain cumulé bien plus important que toute équipe de programmeurs.

Une analyse indépendante de la qualité des logiciels libres a été produite par le Computer Sciences Department de l'University of Wisconsin, illustrant l'importance de la culture du développement sur la qualité des logiciels :

Comment savoir si le succès d'un logiciel libre est possible ? On peut isoler quelques points déterminants pour qu'un logiciel libre se développe avec succès

La qualité technique est un élément déterminant dans le succès des logiciels libres, dans la mesure où le facteur publicité/marketing des logiciels commerciaux est éliminé. Les autres facteurs de succès que l'on peut relever, sont finalement assez logiques et sont directement liés aux signes indicateurs de popularité, de bonne maintenance, d'évolutivité, et de convivialité (installation, documentation) :

Le mode de développement des logiciels libres semble donc être particulièrement compétitif, malgré son apparente anarchie. Vis à vis des logiciels au développement propriétaire, on peut retenir les caractéristiques techniques suivantes dans la majeure partie des cas : des fonctionnalités avancées, une rentabilité maximum des efforts fournis et du temps investi, une amélioration " darwinienne " aboutissant à une efficacité maximum, une très grande fiabilité et un minimum de bugs, un respect des standards supérieur, une garantie de fonctionnement optimale si le suivi est maîtrisé, une liberté de choix supérieure pour les utilisateurs, et finalement la pérennité des solutions choisies.

Voyons ces différents points plus en détail :

Fonctionnalité :

Les logiciels libres sont réalisés par des personnes passionnées par un sujet donné ou par des fonctions particulières. Par conséquent, ils disposent naturellement des fonctionnalités les plus avancées dans leurs domaines respectifs, tandis que les logiciels propriétaires ont davantage tendance à faire évoluer des techniques plus anciennes. Les dernières versions de Windows 98 sont par exemple encore basées sur Ms-Dos qui date de 1981.

D'autre part, les logiciels libres existants peuvent servir de base fiable pour les personnes et les sociétés qui désirent ajouter des fonctionnalités spécifiques non encore couvertes. Ils peuvent recevoir de nouvelles fonctionnalités qui n'auraient jamais été introduites dans un logiciel fermé ou propriétaire vu la spécificité de la demande.

Rentabilité

Ce phénomène permet de gagner énormément de temps et de ressources, puisque ceux qui veulent ajouter une nouvelle fonctionnalité peuvent réutiliser tous les codes sources existants. La déperdition d'énergie dans le développement est minimisée par les mises à jour fréquentes des améliorations. Il est en effet plus simple de repartir d'un logiciel libre existant et de lui ajouter la fonctionnalité recherchée que de repartir à zéro et d'écrire un logiciel complet. Ceci a une incidence importante sur leur rentabilité par rapport aux produits commerciaux au code source protégé, comme nous le verrons dans toute la partie III.

Efficacité

Par l'ouverture des sources et la possibilité de les modifier, les logiciels libres permettent la contribution de tout volontaire. Ces contributions portent parfois sur des petites parties du logiciel, et se font par des personnes différentes dans le monde entier et sans autre rapport que la base de source commune. Ceci permet l'exploration de différentes solutions techniques et la meilleure est généralement retenue, tandis que l'industrie logicielle ne peut pas se permettre une telle recherche. Sur le long terme, grâce à la sélection naturelle (darwinienne pour certains) des solutions techniques, les logiciels libres se révèlent être les plus performants et les plus efficaces en permettant aux utilisateurs de faire du programme ce qu'ils en attendent réellement.

Fiabilité

Toujours grâce à l'ouverture des sources, tout utilisateur sachant le faire a la possibilité de corriger les erreurs éventuelles qu'il peut détecter. Quasiment aucune erreur ne peut donc passer au travers de ce filtrage continu, à laquelle tous les utilisateurs actifs participent. Les logiciels libres atteignent donc une très grande fiabilité en peu de temps.

Compatibilité avec les standards

Les développeurs de logiciels libres favorisent le respect des standards. En effet, seuls les standards garantissent une interopérabilité parfaite avec les autres logiciels. Personne n'a intérêt, dans le monde du libre, à utiliser des protocoles incompatibles ou des formats de fichiers non standards, puisque les sources sont ouvertes et qu'il est impossible d'utiliser les techniques de rétention d'informations classiques dans le but de gagner des parts de marché. Les logiciels libres manipulent donc leurs données sous des formats standards, qui permettent de les récupérer et de les traiter avec d'autres logiciels de manière fiable et à moindre coût.

Garantie de fonctionnement

Professionnellement, la possibilité de modifier les sources garantit que les logiciels vont fonctionner d'une manière ou d'une autre. En effet, avec les logiciels propriétaires, les utilisateurs sont absolument dépendants des sociétés éditrices en cas de problème. Les contrats de service classiques sont non seulement chers, mais souvent inefficaces, car la correction d'un bogue passe souvent par l'attente de la version suivante (et de son achat).

Au contraire, les logiciels libres sont plus réactifs et permettent une correction immédiate, mais ils permettent également aux utilisateurs de choisir la solution à leur problème. Ils peuvent le résoudre eux-mêmes s'ils en ont les moyens, ou sinon louer les services d'une société spécialisée qui assure alors un fonctionnement optimal. Dans les deux cas, les utilisateurs ont l'assurance du bon fonctionnement de leurs logiciels.

Garantie de la liberté

La disponibilité des sources garantit en permanence la liberté de tout utilisateur. Il n'est pas possible, dans un logiciel en open source, d'inclure des fonctionnalités cachées dans le but de restreindre les libertés individuelles ou de collecter des informations sur les utilisateurs (ce que l'on appelle le " spyware ").

Du fait qu'ils respectent les standards, les logiciels libres n'utilisent pas des formats de fichiers non documentés (comme par exemple les différentes versions de Microsoft Word) ou des protocoles de communication propriétaires. Ils garantissent donc la libre circulation des informations et la liberté d'expression de chacun quel que soit son équipement.

De plus, les logiciels libres proposent souvent une ou plusieurs alternatives aux autres logiciels, garantissant ainsi la liberté de choix à leurs utilisateurs.

Pérennité

La disponibilité des sources garantit aux utilisateurs la pérennité des logiciels qu'ils utilisent. L'abandon du support du logiciel par la société éditrice n'est donc pas à craindre.

Comme on l'a vu, l'ouverture des sources, l'importance de la base d'utilisateurs et leur motivation est un élément fondamental dans la rapidité de correction et d'adaptation d'un logiciel libre. Cependant ce facteur constitue une limite dans le cas de logiciels à diffusion réduite ou hautement spécialisés, dont la faible base d'utilisateurs ne permet pas toujours une amélioration coordonnée et efficace. Si l'ouverture des sources permet un développement personnalisé, la base de départ n'existera pas nécessairement dans le cas de logiciels destinés à un public très restreint. Cela n'empêchera pas le développement d'une version au code source ouvert, par exemple par un prestataire de services spécialisé, mais les avantages du modèle coopératif de développement resteront bien moins importants (bien que non nuls).

Un exemple typique est fourni par les logiciels utilisés dans le monde médical ou bancaire, pour lesquels les offres commerciales propriétaires semblent plus adaptées vu les exigences spécifiques de ces secteurs. De même, certains types de logiciels restent encore négligés par les programmeurs open source vu leur relatif manque d'intérêt personnel, comme les logiciels de comptabilité, d'édition sonore ou vidéo, ou encore de modélisation 3D par exemple, bien que certaines ébauches existent (Blender). Le succès d'Apache s'explique aussi par l'intérêt que lui a porté la communauté des développeurs pour laquelle il constituait un modèle de performance, de sécurité et de configurabilité optimale recherchée par le plus grand nombre dans le cas d'un serveur web.

Si le mode de développement des logiciels libres a donc su produire des résultats étonnamment concluants au point de vue technique, comment peut-on accorder une viabilité économique à ces produits totalement étrangers à ces exigences ? Où ces deux mondes opposés peuvent-ils se rejoindre?

Si la majorité des logiciels libres n'est pas développée dans un objectif commercial mais simplement pour répondre aux besoins des utilisateurs, les logiciels libres constituent depuis 1994 un modèle économique pour un certain nombre de sociétés éditrices de logiciels. Ceci peut apparaître paradoxal, vu l'ouverture et la gratuité de fait des logiciels libres, cependant la stratégie de ces acteurs ne se base pas sur la vente de licences contrairement aux éditeurs de logiciels propriétaires.

Ces acteurs majeurs du logiciels libres et de sa promotion commerciale existent depuis 1994 lorsque la société américaine Red Hat Software a adapté et distribué une compilation des sources de Linux disponibles sur l'Internet. Depuis Red Hat a été rejoint par de nombreuses autres sociétés, dont les principales sont SuSE (Allemagne), Mandrake (France), Corel, Caldera, Turbolinux ou encore RedFlag Software pour la Chine. En fait il existe une infinité de distributions plus ou moins dérivées des grands noms comme RedHat et adaptées à un usage ou pays spécifique. Ces distributions respectent la GPL et se trouvent donc librement adaptables, modifiables et même revendables par tous. Il est tout à fait possible de récupérer une distribution existante, de lui ajouter quelques packages logiciels et quelques logos personnels, et de la revendre sous son propre nom. D'ailleurs parallèlement à la vente de distributions sous forme de packs (CD-roms d'installation, manuel et aide en ligne), ces sociétés permettent toujours de télécharger gratuitement leurs dernières versions. Ne possédant pas ce qu'elles vendent, elles n'ont pas à chercher à en limiter la distribution. Au contraire, leurs sources de revenus sont bien davantage basées sur la vente de services associés, où leur expertise peut réellement être monnayée. Cela peut aller du soutien offert aux acheteurs de packs logiciels (qui payent plus un service que les logiciels eux-mêmes), à la mise en place et au déploiement de solutions particulièrement volumineuses basées sur Linux dans les entreprises. Des acteurs comme SuSE, Red Hat ou Turbolinux ont conclu de nombreux accords de partenariats avec les plus grands fabricants de matériel informatique afin de permettre à ces derniers d'enrichir leur offre de solutions logicielles. Red Hat est par exemple lié à IBM, Compaq, Dell, HP, Intel et bien d'autres.

Si les perspectives de profit restent moins importantes qu'avec le système de copyright des logiciels propriétaires, d'un autre coté toute société compétente peut proposer une offre complète de logiciels et de services identique. Le besoin de services sur lequel se base leur stratégie et leur revenus est d'ailleurs bien réel comme le rappelle Bob Young, cofondateur de RedHat :

Les logiciels libres sont pour ces éditeurs un moyen de s'affranchir de la dépendance envers d'autres sociétés, et de pouvoir apporter librement leurs compétences. Aucun frein comme le paiement de royalties ou le manque d'informations sur le fonctionnement du système ne viennent les subordonner aux décisions conceptuelles ou stratégiques d'autres acteurs. Cela permet une compétition plus saine entre les éditeurs de logiciels, dont le succès ne dépend que de la valeur ajoutée qu'ils produisent puisque leurs améliorations iront ensuite enrichir la communauté du logiciel libre dont ils profiteront eux-mêmes en retour. Par exemple, Red Hat est à l'origine du " Red Hat Package Manager ", qui facilite l'installation de logiciels compilés au format rpm. De nombreuses autres distributions ont repris cet outil à leur tour, popularisant le format développé par RedHat.

Ces sociétés cherchent aussi à se diversifier pour conquérir de nouveaux marchés dans lesquels le logiciel libre a un potentiel certain. Par exemple, les Internet Appliances (applications embarquées) et tous les types d'organiseurs personnels reliés à Internet, amenés à se développer fortement, pourront tirer avantage de Linux par ses faibles besoins en ressources, sa forte adaptabilité et l'absence de coûts de licences dans le prix de vente de ces produits.

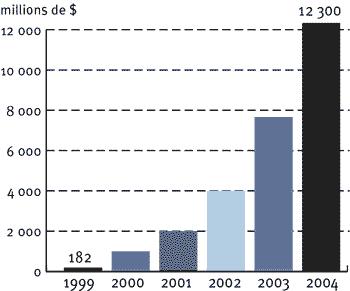

(Source IDC : www.01net.com/rdn?oid=126342)

La production de logicielle du point de vue propriétaire obéit à des règles économiques très particulières, où les coûts se concentrent essentiellement sur la conception et ne concernent plus la production et la distribution que de façon marginale. Cela conduit à des phénomènes de concentration très importants, et la tendance au monopole dans l'économie logicielle apparaît bien plus élevée qu'ailleurs. Ces phénomènes ont pour effets logiques d'accroître la dépendance des utilisateurs, mais aussi de ralentir le progrès technologique à long terme. Voyons en détail les règles et limites de la production logicielle propriétaire :

Une caractéristique importante des biens immatériels comme les logiciels est le rapport élevé entre les coûts fixes d'investissement (plus humains que matériels) pour créer le premier exemplaire d'un bien, et le coût marginal de production. Concevoir un logiciel complexe demandera d'énormes investissements humains et coûtera infiniment plus cher que de le diffuser par la suite. Avec d'une part la progression très importante du taux d'équipement informatique ces dernières années, et d'autre part le développement de l'Internet et des CD-ROM, le phénomène s'est exacerbé par la possibilité de communications massives, ultra-rapides et même interactives, permettant une grande varié de protocoles et donc une diffusion au coût de plus en plus marginal. Par conséquent, pour beaucoup de biens immatériels, on ne peut même plus parler de coût de revient car le coût marginal de production et de distribution peut pratiquement être considéré comme nul (si l'on fait abstraction du service après-vente et des hotlines, qui peuvent être indépendants de la production et de la distribution).

Cette situation conduit dans bien des cas à des phénomènes de concentration allant jusqu'au monopole, qui entravent le bon fonctionnement des mécanismes du développement économique et technologique, et conduisent à une gestion purement financière des ressources scientifiques, technologiques ou culturelles, avec nombre d'effets néfastes. C'est ce qui motive le procès anti-trust contre Microsoft depuis 1998.

Sans revenir sur les nombreux phénomènes qui soutiennent la tendance à la concentration et au monopole dans les secteurs industriels, l'un d'entre eux s'avère particulièrement influent dans l'industrie du logiciel en raison du rôle primordial qu'y jouent les mécanismes de modularité dans la constitution de systèmes très variables et très complexes. Il se fonde principalement sur un cercle vicieux, lié au contrôle des standards par un phénomène de plate-formes et de contenus.

En effet, dès qu'une plate-forme domine le marché, tout créateur commercial de produits (matériel ou logiciel) liés aux plates-formes s'adaptera de préférence à la plate-forme dominante, pour des raisons évidentes de rentabilité. C'est ainsi le cas des fournisseurs de composants pour PC qui fournissent systématiquement les pilotes pour les plates-formes logicielles Microsoft et plus rarement pour les autres (certains modems sont même conçus pour ne fonctionner que sous Windows). C'est encore beaucoup plus vrai pour les éditeurs de logiciels d'application qui, lorsque leur marché est encore concurrentiel, n'ont souvent pas les moyens (ou parfois même l'intérêt économique, comme dans le cas des jeux) de développer pour autre chose que la plate-forme la plus répandue du marché. Ceci renforce encore son caractère dominant puisque les autres plates-formes, possédant alors moins d'applications, ont moins d'attrait. Certains outils comme Direct 3D pour les jeux servent d'ailleurs à encourager le développement sur une seule plate-forme, bien que des alternatives facilement portables comme OpenGL existent.

Ce phénomène est de plus renforcé par la protection légale ou technique des interfaces qui rend difficile, par manque d'information, le développement par d'autres sociétés de logiciels équivalents compatibles sur les plates-formes ainsi négligées. Il est par exemple très difficile d'exploiter sur une plate-forme Unix une encyclopédie prévue pour Windows, alors que cela ne pose en principe aucun problème technique.

De façon générale, cette situation entrave le progrès technologique à long terme. Une fois la concurrence disparue, le seul producteur restant n'a plus véritablement d'intérêt à investir pour améliorer ses produits autant que possible. Le contrôle d'une technologie par une seule société implique que seul un petit nombre de professionnels sera impliqué dans l'amélioration de cette technologie. La recherche universitaire et l'enseignement sont alors entravés ou contrôlés par la rétention de l'information. De plus, la diversité réduite des développements, du fait d'une unique plate forme, limite considérablement les possibilités de progrès par évolution concurrentielle comme entre les distributions de Linux, et augmente la vulnérabilité générale du tissu technologique aux agressions (l'année dernière, quelques virus célèbres ont par exemple pu infecter un nombre très élevé de machines en exploitant une faille du logiciel de messagerie Outlook).

Dans le cadre d'une utilisation en entreprise, les inconvénients sont nombreux. Ne pouvoir disposer que d'un fournisseur unique en matière de solutions logicielles crée une situation de dépendance pour les prix et les services. Il en va de même pour la stratégie à long terme de l'entreprise qui peut dépendre des décisions de son unique fournisseur. Techniquement, la non disponibilité des codes sources (ou leur prix excessif) limite fortement ou interdit aux sociétés clientes toute utilisation et tout service personnalisé, que cela concerne la maintenance, la sécurisation, le portage sur de nouvelles plates-formes ou l'adaptation à des besoins spécifiques. En fait, la société cliente contrôle mal la qualité et la pérennité de son investissement, voire de ses structures informationnelles.

En plus de réduire la dépendance stratégique des entreprises, les logiciels libres peuvent également avoir des effets importants sur l'économie et l'emploi, souvent bien supérieurs à ceux de logiciels contrôlés par des acteurs propriétaires. Comme dans le cas des distributeurs de solutions basées sur Linux, les logiciels libres sont créateurs d'emplois décentralisés (PME) de service, et de nombreuses petites sociétés se créent dans la maintenance ou le développement personnalisé. En supprimant le coût des licences, le logiciel libre autorise une marge supplémentaire en termes d'adaptation, de réactivité et de fiabilité. La simple économie en licences non payées peut servir à payer des ingénieurs pour adapter le logiciel libre aux besoins de l'entreprise et à former les utilisateurs. Ainsi le logiciel libre, adapté sur place, est créateur de plus d'emplois locaux que le logiciel propriétaire importé. Arkane Média, société prestataire de services en logiciels libres basée à Strasbourg, a par exemple reçu le prix de start-up de l'année lors des Trophées de la Nouvelle Economie (http://www.jdnet.fr/lille/010131arkane.shtml).

Ce schéma reste valable au niveau national pour des pays dont les ressources financières sont limitées, mais qui disposent d'une main d'œuvre bien formée ou pouvant l'être, comme nous le verrons en détail dans la partie III)3)B) p50.

Le logiciel libre semble donc tout à fait viable comme modèle économique pour des entreprises éditrices de logiciels. Voyons maintenant quel impact économique peuvent avoir les logiciels libres aux niveaux des utilisateurs professionnels.

À première vue, les mondes du logiciel libre et de l'entreprise sont opposés. Les entreprises ont généralement un point de vue négatif sur le logiciel libre (et Linux en particulier puisque c'est un des logiciels libres les plus connus), bien que l'on observe un changement sensible depuis peu. Ceci est lié à plusieurs raisons : la liberté en elle-même n'est pas toujours un concept bien accepté dans le monde de l'entreprise, le terme "logiciel libre" pouvant au premier abord faire penser à un certain côté "anarchiste". De plus, l'absence de structure régissant le monde du logiciel libre (d'ou son succès comme nous l'avons vu), mis à part des initiatives comme le projet GNU, peut freiner son adoption par l'apparente absence de garantie. Aucune société de taille respectable ne propose actuellement des solutions à base de logiciels libres sur une grande échelle, la société RedHat n'étant qu'un acteur mineur par rapport à des géants comme Microsoft, Sun ou Oracle. Le côté gratuit, couplé à une absence totale de marketing gène donc les décideurs, qui mettent les logiciels libres au même niveau que les logiciels gratuits (freeware), qui ne justifient souvent leur existence que par leur gratuité. Pourtant comme le rappelle la Free Software Foundation, la gratuité d'un logiciel libre n'est qu'un détail et absolument pas sa raison d'être.

Pour définir une politique logicielle, les entreprises se posent en général les questions suivantes avant de savoir si elle est compatible ou utile à la communauté économique :

Contrairement à une idée reçue, mais fausse, la maintenance des logiciels libres est généralement mieux assurée que celle des logiciels commerciaux. La plupart, et surtout les plus importants d'entre eux ont une structure de maintenance organisée, qui peut d'ailleurs évoluer au cours du temps. Grâce au réseau, et à la multiplicité des intervenants, la réactivité aux problèmes qui surviennent est extrêmement grande. On cite souvent l'exemple d'un bogue des logiciels de connection à l'Internet, affectant l'ensemble des systèmes d'exploitation et qui permettait des attaques électroniques contre les serveurs. Après identification du problème, le système libre Linux fut le premier à être corrigé, bien avant l'ensemble des systèmes commerciaux.

En outre, pour des exigences particulières, il reste toujours possible de recourir à une maintenance personnalisée, adaptée précisément à son besoin, et payante comme tout service, grâce à la disponibilité des codes sources. En fait, le développement de l'usage des logiciels libres remplace une activité commerciale centralisée (monopole) d'édition, dont la protection étouffe à terme le développement économique et technologique et qui est fort peu créatrice d'emplois, par une activité commerciale de services, plus créatrice d'emplois décentralisés et plus concurrentielle.

Là aussi, la pérennité sur le long terme peut au moins être assurée par les entreprises elles-mêmes ou par un prestataire de leur choix, grâce à la disponibilité des sources. On peut cependant penser qu'une large communauté d'utilisateurs tendra davantage à pérenniser les produits, car elle contiendra toujours quelques éléments capable d'assurer le suivi technique, comme le montre la pérennisation par leur communauté de systèmes anciens, comme CP/M, qui ont perdu tout intérêt économique (système d'exploitation 8 bits antérieur à Dos, CP/M n'était pas un logiciel libre, mais il était assez simple pour que l'on puisse l'analyser et en faire des simulateurs). Cette pérennité se fonde donc sur une masse d'utilisateurs à l'expérience plus grande que celle assurée par une société commerciale (même importante) qui peut être amenée à abandonner des produits pour des raisons de stratégie industrielle, et à ne plus leur assurer qu'une maintenance dégradée. La disponibilité des sources est donc un gage de pérennité quelque soit le logiciel.

En ce qui concerne des qualités plus immédiates telles que fonctionnalité, performance ou fiabilité, les expériences, les tests, les évaluations et les comparaisons publiés montrent que les grands logiciels libres font souvent au moins jeu égal avec leurs concurrents commerciaux et souvent les dépassent nettement. Une récente comparaison de serveurs de bases de données réalisée par IBM a par exemple montré un très net avantage en performances de la solution sous Linux RedHat à celle sous Windows 2000. (http://www.zdnet.com/filters/printerfriendly/0,6061,2760874-2,00.html et http://www.tpc.org/tpch/results/h-ttperf.idc )

Enfin, pour ce qui est de la compatibilité avec les standards du marché, les logiciels libres, fondés sur la coopération volontaire, intègrent naturellement le respect des normes les plus ouvertes et les plus répandues. En fait, certaines organisations fondées sur le modèle libre, comme l'Internet Society (www.isoc.org), sont même créatrices de standards (appelés RFC) maintenant universellement utilisés. À l'inverse, le développement économique du logiciel commercial se fonde très largement sur des guerres de standards (parfois jusque devant les tribunaux comme pour le langage Java), qui se traduisent pas une rétention d'information et une instabilité permanente et inutile des produits, dont Microsoft Word est un bon exemple. On peut d'ailleurs craindre que le changement constant des formats de représentation, qui de plus ne sont pas documentés publiquement, n'entraîne à terme la perte d'une partie du patrimoine documentaire numérisé.

Les trois scénarios suivants proviennent de l'étude de Jean-Paul Smets-Solanes, Docteur en sciences informatiques (Paris VI). Son étude détaillée des formules mathématiques à l'origine de la modélisation des coûts pour chacun des scénarios est disponible sur http://www.smets.com/it/tco/economie_libre.html. Je reprends ici les conclusions que l'on peut en tirer suite au modèle de calcul des coûts interactif que l'on trouve sur http://www.mmedium.com/dossiers/libre/model.html.

Dans le cadre du déploiement d'un logiciel en entreprise, on peut isoler les trois cas suivants, dont les coûts peuvent être évalués selon ce modèle simple.

Il faut tenir compte du fait qu'une fois le logiciel déployé, des bogues vont probablement être découverts et des fonctionnalités manquantes deviendront nécessaires. Ces défauts, qui peuvent survenir plusieurs fois par an, coûtent chaque jour à l'entreprise en perte de temps des utilisateurs qui doivent redémarrer leur machine, modifier des paramètres, saisir à nouveau des informations... Afin d'en minimiser les coûts, elle peut :

Dans le cas d'un logiciel commercial, il faudra acheter une mise à jour si l'on choisit d'attendre; ou bien acquérir une licence d'accès au code source si l'on choisit de corriger les bogues soi-même. Dans le cas d'un logiciel libre, les mises à jour pourront être effectuées par la communauté des utilisateurs actifs, ce qui signifie aussi que le coût de modification du logiciel sera partagé par l'ensemble des utilisateurs actifs.

Quelle conclusions peut t-on tirer de la comparaison de ces approches selon ce modèle d'évaluation des coûts?

La première conclusion est que développer un logiciel - libre ou non - peut être rentable dès que :

Rendre ensuite ce logiciel libre permet de bénéficier de la réactivité des utilisateurs passifs qui, en signalant les bogues à l'avance, permettent de corriger celles-ci avant qu'elles n'aient de conséquences. L'émergence d'une communauté d'utilisateurs actifs permettra enfin de partager avec eux le coût des modifications et de bénéficier de la réactivité de l'ensemble des autres utilisateurs actifs.

Autrement dit:

Lorsque l'offre de logiciel (libre on non) est insuffisante ou chère, il vaut mieux s'associer pour un créer un nouveau logiciel libre.

La deuxième conclusion que l'on peut tirer ce modèle est que si une panne coûte très cher à l'entreprise et si l'éditeur de logiciel réagit lentement, il vaut mieux (si possible) acquérir le code source du logiciel et corriger soi-même les bogues. Dans ce cas, le logiciel libre dispose d'un avantage financier potentiel puisque non seulement son code source est gratuit mais que le coût des modifications peut être partagé entre plusieurs utilisateurs actifs. De plus certains éditeurs refuseront certainement de divulguer ce qu'ils considèrent comme des informations stratégiques, il suffit de voir la réticence qu'ont certains à seulement diffuser les spécifications nécessaires à la créations de pilotes par les fabricants de hardware.

Autrement dit:

Il vaut mieux aider une petite société à développer un logiciel libre plutôt que de lui acheter un logiciel commercial et de le mettre à jour régulièrement.

Lorsque le délai de réaction de la communauté des utilisateurs actifs d'un logiciel libre coûte trop en dysfonctionnements à certains utilisateurs, ces derniers ont intérêt à modifier eux-mêmes le logiciel et à publier la modification. Ainsi, le nombre d'utilisateurs actifs croît, ce qui fait automatiquement diminuer le délai moyen de réaction jusqu'à ce que l'on atteigne un état d'équilibre : chaque utilisateur corrige le bogue qui compte le plus pour lui. Notons que, selon de nombreuses études, les logiciels libres ainsi maintenus sont aujourd'hui les moins bogués du marché.

Autrement dit:

Il existe un équilibre économique garantissant un nombre d'utilisateurs actifs suffisant pour satisfaire les utilisateurs les plus exigeants.

Toutes les entreprises utilisatrices ne choisiront pas de modifier elles-mêmes le logiciel, mais le fait de pouvoir sous-traiter cette activité est très important On constate immédiatement que le logiciel libre, en supprimant le coût des licences, autorise une marge appréciable en termes d'adaptation, de réactivité et de fiabilité. Si l'on omet les paramètres réactivité et fiabilité, ce que l'on gagne en licences non payées peut servir à payer des ingénieurs pour adapter le logiciel libre aux besoins de l'entreprise et à former les utilisateurs.

- Quelques exemples concrets suivant ces trois scénarios

Si l'entreprise souhaite installer un serveur Web, les choix possibles sont par exemple le serveur Web Microsoft sous Windows NT ou 2000 et le serveur Apache sous RedHat Linux. Ces deux serveurs sont similaires du point de vue des fonctionnalités mais Apache est réputé plus fiable et ses bogues sont corrigées plus rapidement. À moins d'une bonne raison, il vaut donc mieux choisir Apache puisqu'il coûte moins cher au départ et moins cher ensuite chaque année.

Comparons maintenant deux petits serveurs de base de données ; considérons par exemple le logiciel commercial FileMaker Pro (MacOS) et le logiciel libre MySQL (Linux). Adapter FileMaker Pro pour définir une application d'entreprise demande moins d'effort qu'avec MySQL. En revanche, MySQL est plus éprouvé et son éditeur, TCX, corrige les bogues plus rapidement que l'éditeur de FileMaker..

Le choix du logiciel libre est le meilleur si le nombre de postes à équiper est important ou si l'application est stratégique. Le surcoût d'adaptation du logiciel libre par rapport au logiciel commercial sera probablement compensé par l'absence de licence et, le cas échéant, rentabilisé sur le long terme grâce à une meilleure fiabilité et une meilleur réactivité. Un exemple intéressant est celui du moteur de recherche Google, qui utilise plus de 4000 serveurs à base de PC bon marché, fonctionnant en réseau sous Linux. Ce fut pour cette société un moyen d'obtenir une puissante base de données à faible coût et dont la puissance peut-être facilement adaptée en augmentant le nombre de postes.

En revanche, si l'objectif est de monter très rapidement et en un seul exemplaire une base de données moyennement fiable, mieux vaut choisir le logiciel commercial car il reviendra moins cher à adapter. A petite échelle les solutions commerciales peuvent s'avérer plus intéressantes.

Comparons maintenant FrameMaker, un logiciel commercial de mise en page scientifique pour MacOS, et KLyX, un logiciel libre de publication scientifique pour Linux.

FrameMaker permet de réaliser des mises en pages complexes plus rapidement que KLyX grâce à une interface élégante qui gère les modèles de mise en page, les feuilles de styles, le placement des images, les liens hypertexte, la séparation quadrichromique, la conversion HTML, etc. Mais KLyX offre des avantages par rapport à FrameMaker pour l'automatisation du processus de rédaction et la gestion des formules mathématiques complexes.

FrameMaker est un produit stable. KLyX est un logiciel en développement qui fonctionne bien pour des tâches simples mais doit encore évoluer pour offrir que même degré de convivialité que FrameMaker pour les tâches complexes.

Dans une logique de court et moyen terme, le logiciel libre KLyX ne sera choisi que si le nombre de postes devant être équipé est élevé et si le coût des bogues est bas. Autrement dit, pour faire taper des documents simples à de nombreux employés peu payés, l'utilisation d'un logiciel libre de moins bonne qualité qu'un logiciel commercial peut être rentable.

On peut ici reprendre l'exemple de la firme Lectra qui a envisagé il y a 4 ans deux systèmes d'exploitation pour développer son système de CAO textile : Windows et Linux.

C'est donc Linux qui a été choisi. Cependant , ce choix pourrait être remis en question si Windows était plus fiable et si son code source était disponible.